filmov

tv

Лекция 8. Линейная регрессия

Показать описание

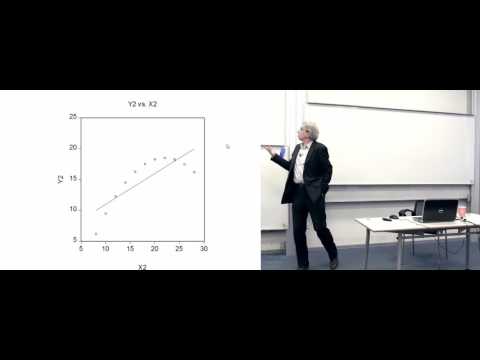

Линейный регрессионный анализ. Модель, интерпретация оценок коэффициентов, множественный коэффициент детерминации. Интерпретация множественного коэффициента детерминации, ограничения на область его применения. Выявление наиболее значимых предикторов и оценка вклада каждого предиктора. Алгоритмы корректировки построенных моделей. Коллинеарность.

Лекция №8 в курсе "Анализ данных на Python в примерах и задачах. Часть 1" (весна 2018).

Преподаватель курса: Вадим Леонардович Аббакумов

Лекция 8. Линейная регрессия

Лекция 8. Линейная регрессия - анализ остатков. Экспоненциальное сглаживание...

Лекция 8. Множественная линейная регрессия

Лекция 8. Прогнозирование. Линейная регрессия. Нелинейная и множественная регрессии....

Лекция 2.1: Линейная регрессия.

РЕАЛИЗАЦИЯ ЛИНЕЙНОЙ РЕГРЕССИИ | Линейная регрессия | LinearRegression | МАШИННОЕ ОБУЧЕНИЕ...

Прикладной Python | Machine Learning | Лекция №8: 'Линейная регрессия'...

BigData Лекция №8 'Регрессия'

Лекция 8. Линейные модели II

Линейная регрессия. Что спросят на собеседовании? ч.1

Логистическая регрессия. Лекция 8.

Линейная регрессия в Python за 13 МИН для чайников [#Машинное Обучения от 16 летнего Школьника]...

МСПС. Лекция 8. Регрессионный анализ I.

Лекция. Регуляризация в линейной регрессии

Основы машинного обучения, лекция 8 — линейная классификация...

Введение в анализ данных, лекция 8 — линейная классификация, метрики качества классификации...

Лекция 8 | Основы байесовского вывода | Сергей Николенко | Лекториум...

Семинар 8. Прогнозирование. Линейная регрессия. Метод наименьших квадратов....

Основы машинного обучения, лекция 8 — линейная классификация...

Машинное обучение: линейная регрессия.

Линейная Регрессия для Дата Саентиста

Прикладная статистика. Лекция 8.

Линейная регрессия, метод наименьших квадратов, матфак ВШЭ, 2022-01-31...

Open ML Course: Линейные модели | Лекция 1. Линейная регрессия

Комментарии

1:10:53

1:10:53

1:38:01

1:38:01

1:15:38

1:15:38

1:06:26

1:06:26

0:19:42

0:19:42

0:36:49

0:36:49

1:41:59

1:41:59

1:08:38

1:08:38

1:16:08

1:16:08

0:14:03

0:14:03

1:14:12

1:14:12

0:13:30

0:13:30

1:16:28

1:16:28

0:05:03

0:05:03

1:09:01

1:09:01

1:23:26

1:23:26

1:29:39

1:29:39

1:23:37

1:23:37

0:47:25

0:47:25

0:00:55

0:00:55

1:37:56

1:37:56

1:31:31

1:31:31

1:18:29

1:18:29

0:43:51

0:43:51