filmov

tv

[DeepLearning | видео 2] Градиентный спуск: как учатся нейронные сети

Показать описание

[DeepLearning | видео 2] Градиентный спуск: как учатся нейронные сети...

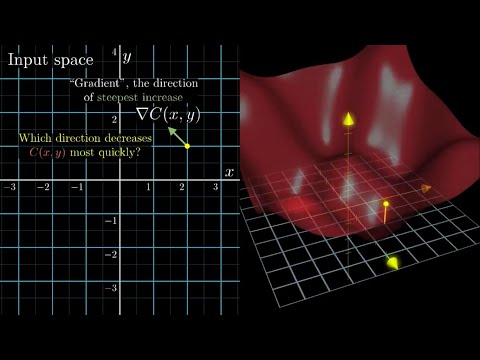

Gradient descent, how neural networks learn | Chapter 2, Deep learning

Gradient Descent With Momentum (C2W2L06)

What is backpropagation really doing? | Chapter 3, Deep learning

Mini Batch Gradient Descent (C2W2L01)

Лекция. Градиентный спуск в линейных алгоритмах

Лекция 2.4: Градиентный спуск.

Vanishing/Exploding Gradients (C2W1L10)

But what is a neural network? | Chapter 1, Deep learning

Deep Learning Theory 2-1: When Gradient is Zero

Deep Learning(video 1) - Linear Regression with Gradient Descent

Gradient Descent For Neural Network | Deep Learning Tutorial 12 (Tensorflow2.0, Keras & Python)

Gradient descent simple explanation|gradient descent machine learning|gradient descent algorithm

Recurrent Neural Networks (RNNs), Clearly Explained!!!

Adding gradient descent | Building deep learning library! part 3

L12.0: Improving Gradient Descent-based Optimization -- Lecture Overview

What is Gradient Checking | #shorts | Data Science Interview Question | Machine Learning

Deep Learning tutorial part 2. Mathematics of gradient descent

Neural Networks explained in 60 seconds!

Gradient Descent 📉 for Neural Network using Python

Gradient descent with momentum

Gradient Descent, Step-by-Step

Exploding Gradient Problem | Deep Learning | Tutorial

Algorithmic Minute: gradient descent with JuliaLang

Комментарии

0:20:52

0:20:52

0:20:33

0:20:33

0:09:21

0:09:21

0:12:47

0:12:47

0:11:29

0:11:29

0:12:01

0:12:01

0:12:01

0:12:01

0:06:08

0:06:08

0:18:40

0:18:40

1:17:29

1:17:29

0:26:38

0:26:38

0:41:34

0:41:34

0:15:39

0:15:39

0:16:37

0:16:37

0:10:32

0:10:32

0:06:19

0:06:19

0:00:59

0:00:59

0:21:24

0:21:24

0:01:00

0:01:00

0:00:42

0:00:42

0:00:56

0:00:56

0:23:54

0:23:54

0:11:52

0:11:52

0:00:53

0:00:53