filmov

tv

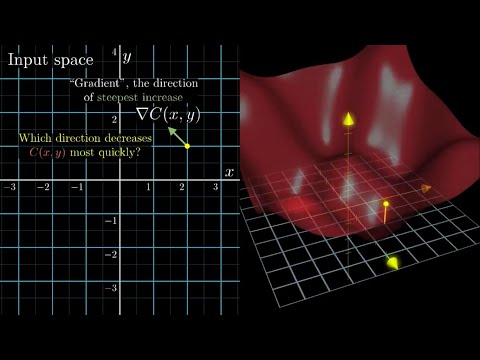

Лекция 2.4: Градиентный спуск.

Показать описание

Занятие ведёт Григорий Лелейтнер.

Ссылки на все части:

---

Deep Learning School при ФПМИ МФТИ

Каждые полгода мы запускаем новую итерацию нашего двухсеместрового практического онлайн-курса по глубокому обучению. Наборы проводятся в августе-сентябре и январе-феврале.

За нашими новостями можно следить здесь:

ФПМИ МФТИ

Ссылки на все части:

---

Deep Learning School при ФПМИ МФТИ

Каждые полгода мы запускаем новую итерацию нашего двухсеместрового практического онлайн-курса по глубокому обучению. Наборы проводятся в августе-сентябре и январе-феврале.

За нашими новостями можно следить здесь:

ФПМИ МФТИ

Лекция 2.4: Градиентный спуск.

Лекция 2 | Линейная регрессия, градиентный спуск | Машинное обучение...

2.3. Градиентный спуск для функций многих переменных

#015 ML Основы нейросетей ч.2 Градиентный спуск

Машинное обучение - Линейная регрессия, градиентный спуск, метрика качества R^2 - Семинар №4...

Лекция. Градиентный спуск в линейных алгоритмах

ИИ, нейросети, лекция-2: градиентный спуск с сигмоидой по косточкам, нелинейный нейрон...

2.4 Модификации градиентного спуска

[DeepLearning | видео 2] Градиентный спуск: как учатся нейронные сети...

Численные методы оптимизации 2. Градиентный спуск

AIML-4-2-2 Метод градиентного спуска

Нейронные Сети на Понятном Языке | Градиентный Спуск | #2...

Лекция 5. Линейная классификация и градиентный спуск

Линейная регрессия. Что внутри sklearn? Зачем градиентный спуск? Что спросят на собеседовании? ч.2...

Машинное обучение 1, лекция 4 — градиентный спуск, регуляризация...

06.04, НИС 2, 3, Градиентный спуск, наискорейший спуск, сложность задач невыпуклой оптимизации...

Семинар 16. Градиентный спуск\поток. Сходимость в выпуклом случае. Наискорейший спуск. МФТИ. 2022...

Лекция #4. Стохастический градиентный спуск.

Методы оптимизации 2. Выпуклость и гладкость. Градиентный спуск...

Градиентный спуск на пальцах

2. Искусственные нейронные сети. Линейная регрессия, регуляризация, переобучение и градиентный спуск...

Лекция 2. Градиентный бустинг

СПбГУ -- 2021.09.13 -- Backpropagation и стохастический градиентный спуск...

Градиентный спуск

Комментарии

0:12:01

0:12:01

2:13:56

2:13:56

0:10:31

0:10:31

0:27:38

0:27:38

1:16:26

1:16:26

0:12:01

0:12:01

2:18:31

2:18:31

0:25:14

0:25:14

0:20:52

0:20:52

1:20:12

1:20:12

0:09:14

0:09:14

0:06:05

0:06:05

0:47:34

0:47:34

0:11:48

0:11:48

1:22:21

1:22:21

1:52:56

1:52:56

1:11:05

1:11:05

1:24:51

1:24:51

1:23:51

1:23:51

0:11:22

0:11:22

1:04:04

1:04:04

1:35:06

1:35:06

1:37:42

1:37:42

0:12:11

0:12:11