filmov

tv

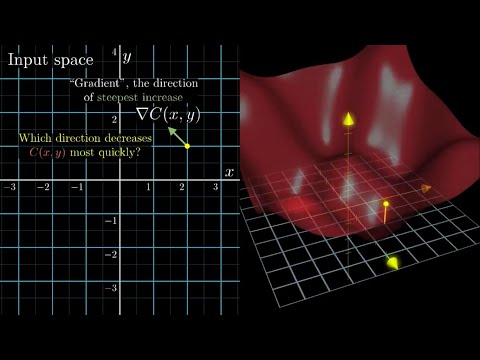

Градиентный спуск на пальцах

Показать описание

Градиентный спуск, самое простое объяснение без обрезания важного

00:00 Задача оптимизации

02:05 Градиентный спуск

05:32 Несколько функций (объектов)

10:27 Резюме

00:00 Задача оптимизации

02:05 Градиентный спуск

05:32 Несколько функций (объектов)

10:27 Резюме

Градиентный спуск на пальцах

Машинное обучение: градиентный спуск для новичков с практикой в Python...

[DeepLearning | видео 2] Градиентный спуск: как учатся нейронные сети...

Что Такое ГРАДИЕНТНЫЙ СПУСК? #shorts #авекодер

2.3. Градиентный спуск для функций многих переменных

ИМРС 4.3 Метод градиентного спуска

Градиентный метод | метод скорейшего спуска + пример

Нейронные Сети на Понятном Языке | Градиентный Спуск | #2...

Решим задачу: шаг градиентного спуска

СТОХАСТИЧЕСКИЙ ГРАДИЕНТНЫЙ СПУСК #shorts #авекодер

Лекция 2.4: Градиентный спуск.

Простой градиентный спуск

Оптимизация: метод градиентного спуска с постоянным шагом. Функция f(x, y) = x^2 + 9y^2, c = 14....

ЦОС Python #3: Метод градиентного спуска для двух параметров...

17.04, НИС 1, Градиентный спуск с постоянным шагом

Градиентный спуск на Keras и TF | Gradient Descent | Neural Networks (NN) | НЕЙРОННЫЕ СЕТИ 3...

ПРИЕДУ ДОМОЙ, изучу стохастический градиентный спуск более подробно 💪...

Методы Оптимизации. Семинар 22. Стохастический градиентный спуск...

Visualization of Gradient Descent

#8. Стохастический градиентный спуск SGD и алгоритм SAG | Машинное обучение...

Чтобы разбогатеть тебе нужен градиентный спуск

#015 ML Основы нейросетей ч.2 Градиентный спуск

Градиентный бустинг с нуля на Python / Data Science

Лекция. Градиентный спуск в линейных алгоритмах

Комментарии

0:11:22

0:11:22

0:15:17

0:15:17

0:20:52

0:20:52

0:00:13

0:00:13

0:10:31

0:10:31

0:18:29

0:18:29

0:17:12

0:17:12

0:06:05

0:06:05

0:06:25

0:06:25

0:00:17

0:00:17

0:12:01

0:12:01

0:00:47

0:00:47

0:02:18

0:02:18

0:14:14

0:14:14

0:54:07

0:54:07

0:35:42

0:35:42

0:00:49

0:00:49

1:22:15

1:22:15

0:00:11

0:00:11

0:17:33

0:17:33

0:15:05

0:15:05

0:27:38

0:27:38

0:15:24

0:15:24

0:12:01

0:12:01