filmov

tv

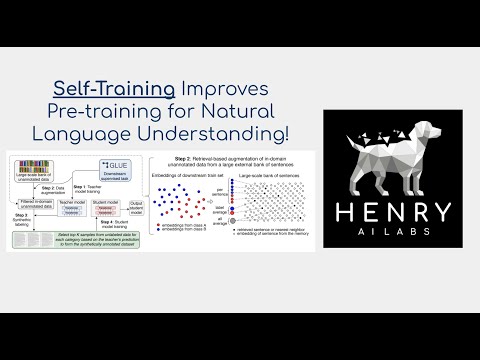

Self-training Improves Pre-training for Natural Language Understanding

Показать описание

안녕하세요 딥러닝 논문읽기 모임입니다 오늘 논문은 페이스북과 스탠포드에서 2020년에 발표한 'Self-training Improves Pre-training for Natural Language Understanding' 라는 제목의 논문입니다!

논문은 이미지처리 부분에서 Pre-training과 Self training을 합쳤을때

더 나은 결과를 도출할 수 있다는 연구를 진행한 논문입니다!

그리고 Unsupervised Data Augmentation for Consistenct Training과

Self-training with Noisy student improves ImageNet classification 이 두개의 논문은 Self training에 있어서 가장 중요한 건 Unlabel 데이터가 downstream task와 같은 In-domain데이터가 있는 것이 얼마나 중요한지 연구된 논문입니다!

오늘 논문 리뷰를 위해 펀디멘탈팀 김지연님이 자세한 리뷰 도와주셨습니다!

오늘도 많은 관심 미리 감사드립니다!

논문은 이미지처리 부분에서 Pre-training과 Self training을 합쳤을때

더 나은 결과를 도출할 수 있다는 연구를 진행한 논문입니다!

그리고 Unsupervised Data Augmentation for Consistenct Training과

Self-training with Noisy student improves ImageNet classification 이 두개의 논문은 Self training에 있어서 가장 중요한 건 Unlabel 데이터가 downstream task와 같은 In-domain데이터가 있는 것이 얼마나 중요한지 연구된 논문입니다!

오늘 논문 리뷰를 위해 펀디멘탈팀 김지연님이 자세한 리뷰 도와주셨습니다!

오늘도 많은 관심 미리 감사드립니다!

0:26:26

0:26:26

0:17:53

0:17:53

0:04:55

0:04:55

0:27:18

0:27:18

0:10:13

0:10:13

0:21:57

0:21:57

0:18:46

0:18:46

0:01:00

0:01:00

0:24:44

0:24:44

0:05:20

0:05:20

0:24:51

0:24:51

0:20:16

0:20:16

0:32:46

0:32:46

0:08:37

0:08:37

0:09:54

0:09:54

0:40:13

0:40:13

1:18:46

1:18:46

0:14:21

0:14:21

0:00:55

0:00:55

0:27:23

0:27:23

0:13:19

0:13:19

0:24:31

0:24:31

0:12:47

0:12:47

0:08:50

0:08:50