filmov

tv

Как работают RNN. Глубокие рекуррентные нейросети | #22 нейросети на Python

Показать описание

Что дает рекурсия рекуррентным нейронным сетям и как ее можно выразить на языке математики. Примеры архитектур глубоких сетей: Deep Transition RNN (DT-RNN), Deep Transition Deep Output RNN (DOT-RNN), Stacked RNN. Пример реализации Stacked RNN в Keras.

Как работают RNN. Глубокие рекуррентные нейросети | #22 нейросети на Python...

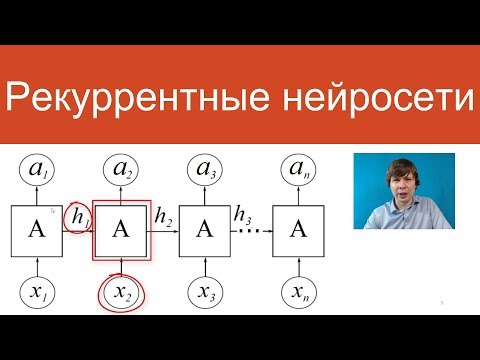

Лекция. Рекуррентная нейронная сеть

Введение в рекуррентные нейронные сети | #19 нейросети на Python...

10.1 Глубокое обучение и вообще: рекуррентные нейронные сети и временные ряды...

СПбГУ -- 2022.11.02 -- Рекуррентные нейронные сети

RNN

Сети LSTM и GRU | Нейросети для анализа текстов

Семинар. Рекуррентные нейронные сети

PyTorch - рекуррентные нейронные сети

Двунаправленные (bidirectional) рекуррентные нейронные сети | #26 нейросети на Python...

LSTM - долгая краткосрочная память | #23 нейросети на Python

Лекция. Обучение рекуррентной нейронной сети

Нейчев Р.Г. - Введение в глубокое обучение - 7. Языковое моделирование и RNN...

Машинное обучение 12. RNN

Рекуррентные сети: 1. Введение

СПбГУ -- 2021.11.08 -- Рекуррентные нейронные сети

Глубокие рекуррентные нейронные сети

№2 Рекуррентные нейронные сети. Улучшенные методы рекуррентных нейронных сетей...

Ганичев А.А. - Нейронные сети в научных исследованиях - 8. Рекуррентные нейронные сети...

Рекуррентные сети. Как нейронные сети анализируют текст?...

Лекция 9 - RNNs

Рекуррентные нейросети | Нейросети для анализа текстов...

СПбГУ -- 2020.11.05 -- Рекуррентные нейронные сети

6. Рекуррентные нейронные сети | Краткий курс по нейронным сетям...

Комментарии

0:09:31

0:09:31

0:16:54

0:16:54

0:12:09

0:12:09

1:28:53

1:28:53

0:53:17

0:53:17

0:12:28

0:12:28

0:15:02

0:15:02

0:48:34

0:48:34

0:17:21

0:17:21

0:09:16

0:09:16

0:15:35

0:15:35

0:10:47

0:10:47

1:32:16

1:32:16

1:24:20

1:24:20

0:04:31

0:04:31

1:29:48

1:29:48

0:56:39

0:56:39

0:07:46

0:07:46

1:34:34

1:34:34

0:11:41

0:11:41

1:21:49

1:21:49

0:14:29

0:14:29

1:29:45

1:29:45

0:17:40

0:17:40