filmov

tv

DataOps TUTORIAL: Data engineering / Ejemplo DAGSTER end-to-end con BigQuery, dbt, spark, jupyter

Показать описание

#dataOps #dataengineering #dagster #dbt #bigQuery #SPARK

* BigQuery como DWH

* dbt como herramienta de transformación de datos SQL

* dataproc/pySpark para procesar datos a escala con SPARK

* Jupyter notebook, para explorar y visualizar el resultado

Sígueme en:

👉twitter: @luisvelasco

* BigQuery como DWH

* dbt como herramienta de transformación de datos SQL

* dataproc/pySpark para procesar datos a escala con SPARK

* Jupyter notebook, para explorar y visualizar el resultado

Sígueme en:

👉twitter: @luisvelasco

What is DataOps?

What is DataOps?

DataOps TUTORIAL: Data engineering / Ejemplo DAGSTER end-to-end con BigQuery, dbt, spark, jupyter

3 Must-Know Trends for Data Engineers | DataOps

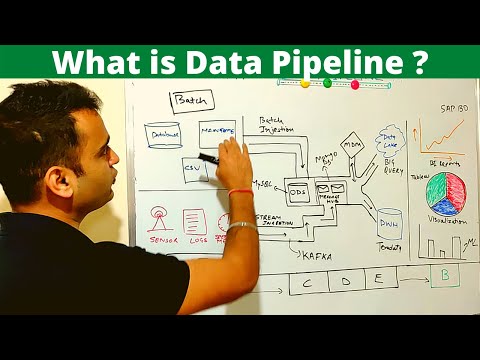

What is Data Pipeline | How to design Data Pipeline ? - ETL vs Data pipeline (2024)

DataKitchen DataOps Demo

Automating Data Management with DataOps

What is DataOps? | The Data Pinch Ep. 31

Data Quality: Understanding Garbage In, Garbage Out

DataOps 101 - Why, What, How?

What is DataOps | DataOps in Practice | DataOps Implementation | DevOps Training | Edureka

How to Build a Modern DataOps Team

TUTORIAL Data Engineering: Calidad de datos desde la perspectiva DataOps con 'Great Expectation...

Fundamentals Of Data Engineering Masterclass

What is DataOps ?

Data Engineer's Lunch #20: DataOps vs. DevOps

DataOps – The Foundation for Your Agile Data Architecture

How to use RDD API in Databricks

Learn Apache Airflow in 10 Minutes | High-Paying Skills for Data Engineers

Cloud Next – DataOps and Data Engineering Best Practices

How to monitor Spark and Python data pipelines with DataOps

Dataops for the Modern Data Stack and how to get started

What is a Data Pipeline Engineer?

DataOps –The Foundation for Your Agile Data Architecture

Комментарии

0:02:43

0:02:43

0:05:02

0:05:02

0:08:05

0:08:05

0:10:34

0:10:34

0:19:49

0:19:49

0:05:42

0:05:42

0:01:56

0:01:56

0:09:14

0:09:14

0:32:51

0:32:51

0:22:55

0:22:55

0:24:28

0:24:28

0:53:02

0:53:02

3:02:26

3:02:26

0:14:19

0:14:19

0:58:00

0:58:00

1:00:22

1:00:22

0:00:32

0:00:32

0:12:38

0:12:38

0:09:31

0:09:31

0:15:39

0:15:39

0:28:22

0:28:22

0:00:20

0:00:20

1:00:22

1:00:22