filmov

tv

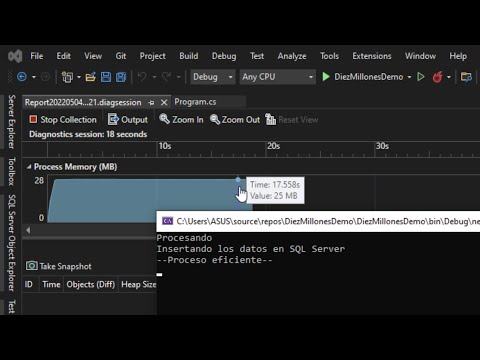

Insertando 10 millones de Registros en SQL Server con C# y ADO.NET (Modo Eficiente)

Показать описание

Insertando 10 millones de Registros en SQL Server con C# y ADO.NET (Modo Eficiente)

Inserción MASIVA de datos, BULK INSERT en Sql Server

Entity Framework 7, Trabajar con MILLONES de Datos en .NET 7

¿Cómo insertar miles de registros con Entity Framework? | C# .Net

Como importar mas de un millón de registros desde Excel | 5 motivos para integrar Access y Excel 1

Inserting 10 Million Records in SQL Server with C# and ADO.NET (Efficient way)

Bases de datos mas grandes de lo que permite Excel - POWERPIVOT

Como manejar bases Datos gigantes excel (usando Power Pivot)

3 formas de insertar registros en una tabla de SQL Server

📊 Gráfico en Excel para comparar ventas por mes y año #shorts

Insertando datos en forma corta con la instrucción INSERT INTO

Unos pulmones 🫁 sanos.Como se hinchan lis pulmones sololando.#pulmones #shorts #reels #tiktok

Actualización Incremental en Power BI - Incremental Refresh

Súper consejo #shorts

Importar datos con bulk insert en MS SQL Server / bulk insert in SQL Server

Pasando un Listado o Arreglo a un Procedimiento Almacenado | C# | SQL Server | ASP.NET Core 6

🏳️⚧️Mi transición de niño a una mujer trans

Conectar e Insertar Datos C# SQL SERVER (1/6)

Como EXTRAER DATOS de una BASE DE DATOS en EXCEL || Función BDEXTRAER

¿Cómo enviar una lista como parámetro a SQL Server desde C# .Net? | Entity Framework

Gráfico de barras en Excel, personalizado 📊

Nivel 34 - Reto 7 - Insertar registros en una tabla mediante el comando INSERT INTO

Optimizando consultas en SQL Server #1 - Guia de SQL Server en Español

Cómo presentar datos IMPACTANTES con GRÁFICOS en Excel, tutorial paso a paso.

Комментарии

0:07:26

0:07:26

0:08:33

0:08:33

0:12:40

0:12:40

0:15:17

0:15:17

0:07:25

0:07:25

0:06:45

0:06:45

0:07:54

0:07:54

0:09:36

0:09:36

0:09:03

0:09:03

0:01:01

0:01:01

0:20:23

0:20:23

0:00:12

0:00:12

0:21:16

0:21:16

0:00:13

0:00:13

0:07:11

0:07:11

0:12:13

0:12:13

0:00:10

0:00:10

0:19:32

0:19:32

0:08:15

0:08:15

0:13:55

0:13:55

0:06:03

0:06:03

0:08:07

0:08:07

0:04:47

0:04:47

0:10:19

0:10:19