filmov

tv

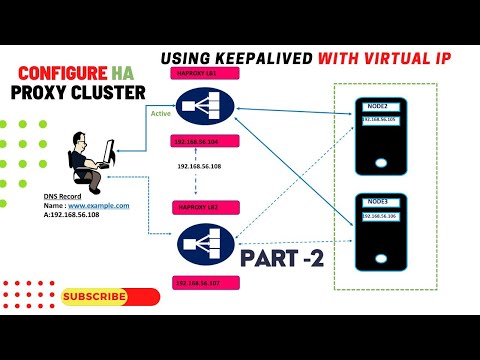

HAPROXY - 14. Keepalived & Haute Disponibilité (vip)

Показать описание

Haproxy c'est bien mais à lui seul il ne suffit pas pour faire de la hatue disponibilité. En effet Haproxy est un spof dans une infrastructure sauf si l'on doublonne ce service et que l'on fait répondre à une VIP. C'est là que KeepAlived intervient et forme un jolie duo avec notre loadbalancer.

Keepalived va nous permettre de switcher une vip suivant l'état du service haproxy.

Playlists:

A bientôt !!

Keepalived va nous permettre de switcher une vip suivant l'état du service haproxy.

Playlists:

A bientôt !!

HAPROXY - 14. Keepalived & Haute Disponibilité (vip)

Configure HA Cluster using KeepAlived with FloatingIP | Install KeepAlived on Ubuntu

Meet keepalived - High Availability and Load Balancing in One

Setup Active-Passive Cluster with Keepalived & HAProxy (Two raspberry pis)

Building a highly available load balancer with keepalived and HAProxy

Wysokodostępny loadbalancer czyli HaProxy z Keepalived

HAProxy ve Keepalived ile HA Yapı kurulumu | Ubuntu 20.04

how to setup haproxy with keepalived on centos |Configure Highly Available HAProxy with Keepalived

keepalived VRRP High Availability in short

Configuración Keepalived - Haproxy (High availability) IpVirtual

a load balancing scenario using HAProxy and keepalived shows no performance advantage

HAProxy+Keepalived: Build Your Load Balancer in 30 Minutes

Creating Highly Available Clusters with kubeadm-ha-keepalived-haproxy

how to configure HA For Linux Server Configuring Keepalived 1

haproxy ha with keepalived automate ansible

DevOps & SysAdmins: How to use Docker with HAProxy+Keepalived?

[ Kube 113.6 ] Kubesphere | HA setup with Keepalived & Haproxy

Load balancing dengan Haproxy dan Keepalived

vagrant haproxy et keepalived (LB+HA)

Greenplum HA Keepalived PoC - Master process died

Formation : Loadbalacing et haute disponibilité avec Haproxy + Squid + Keepalived

Apache High Avibiliter HAProxy & Keepalived Centos /redhat part3

KUBERNETES - 37. HAUTE DISPO : HAPROXY ET KEEPALIVED

KeepAlived - Part 2 [VoIP Service Resilience With Virtual Router Redundancy Protocol ]

Комментарии

0:15:54

0:15:54

0:08:49

0:08:49

0:18:11

0:18:11

0:18:56

0:18:56

0:19:10

0:19:10

0:24:30

0:24:30

0:07:03

0:07:03

0:13:32

0:13:32

0:00:36

0:00:36

0:14:20

0:14:20

0:01:40

0:01:40

0:26:16

0:26:16

0:00:55

0:00:55

0:08:19

0:08:19

0:02:43

0:02:43

0:02:07

0:02:07

0:26:15

0:26:15

0:19:11

0:19:11

0:29:56

0:29:56

0:09:34

0:09:34

0:09:27

0:09:27

0:26:36

0:26:36

0:12:17

0:12:17

0:15:13

0:15:13