filmov

tv

PR-256: GPT-3 : Language Models are Few-Shot Learners

Показать описание

PR12에서 이번에 발표한 논문은 GPT-3로 알려져 있는 'Language Models are Few-Shot Learners' 라는 논문입니다. 이 논문은 pretrain + finetune 하는 기존 방식에서 벗어나, pretrain을 엄청난 크기의 모델(기존 최대 대비 10배) 에하고 task description + few shot learning을 통해 좋은 결과를 낸 논문입니다.

PR-256: GPT-3 : Language Models are Few-Shot Learners

GPT-3: Language Models are Few-shot Learners

GPT-3 - 'Language Models Are Few Shot Learners' Presentation

Language Models are Few-Shot Learners -- GPT-3 Paper

Language Models are Few Shot Learners - Presented by Abdullah AbuNada

How to have your own Offline Chat AI (Like ChatGPT)

LLMs with 8GB / 16GB

EASIEST Way to Fine-Tune a LLM and Use It With Ollama

Small Language Models Are Also Few-Shot Learners

GPT-3 Live Demo in under 30 Minutes + Q&A Session | Zack Lee, Lead AI Engr at copy.ai

I built an AI supercomputer with 5 Mac Studios

Master Any AI in 2025: Ultimate Comparison Guide (from ChatGPT to Gemini)

AI vs. Intelligence? #Shorts

GPT3: Zero shot, One shot, Few shot example | code

iPhone 16 Pro Max Apple Intelligence Siri 2.0

Top GPT-3 Projects - 16 applications built on OpenAI GPT-3 Text Generation AI

Claude 3.5 just SHOCKED the ENTIRE INDUSTRY! (First GPT-5 level model)

Learn Ollama in 15 Minutes - Run LLM Models Locally for FREE

the future of GPUs #shorts

AI World War 1 Just Began: SHOCKING New AI (Tülu 3) Destroys DeepSeek & OpenAI!

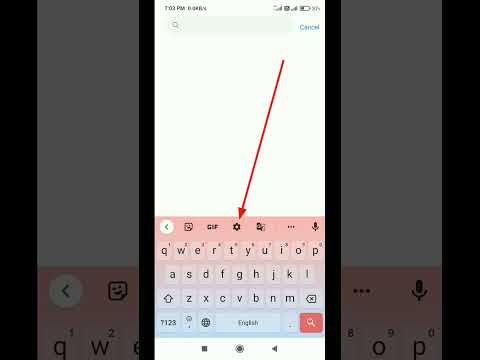

Keyboard Settings Double Space Full Stop #shorts #uniquetechtips

Introducing the HP Pavilion 15 (2023) Intel 13th Gen laptop🔥✨ #hp #hppavilion #intel13thgen

Llama 3.3 70B - THE BEST LOCAL AI YET!

Combine Hard Drive Partitions in Windows 10 | How to Combine Hard Drive/Ssd Partition#macnitesh#HDD

Комментарии

0:39:31

0:39:31

2:54:33

2:54:33

0:19:46

0:19:46

0:15:26

0:15:26

0:28:32

0:28:32

0:02:34

0:02:34

0:11:09

0:11:09

0:05:18

0:05:18

0:20:51

0:20:51

1:21:23

1:21:23

0:34:57

0:34:57

0:26:18

0:26:18

0:00:46

0:00:46

0:06:10

0:06:10

0:00:11

0:00:11

0:12:31

0:12:31

0:09:38

0:09:38

0:14:02

0:14:02

0:00:09

0:00:09

0:10:54

0:10:54

0:00:14

0:00:14

0:00:23

0:00:23

0:19:17

0:19:17

0:00:16

0:00:16