filmov

tv

Основы нейронных сетей и Deep Learning | Технострим

Показать описание

Мероприятие: Moscow Data Science Junior Meetup, 10.06.2017

Нейронные сети – одна из самых горячих тем в машинном обучении последних лет. В докладе речь пойдет об основах DL: обратном распространении ошибки и стохастическом градиентном спуске. Мы обсудим MLP и сверточные сети. Как читать обозначения в статьях, что такое 1х1 и дырявые свертки. Чем global pooling отличается от обычного и т.д.

О КАНАЛЕ:

Официальный канал образовательных проектов Mail.Ru Group

Актуальные лекции и мастер-классы о программировании от лучших IT-специалистов. Если вы увлечены мобильной и веб-разработкой, присоединяйтесь!

Наши проекты:

------------------------

МЫ В СЕТИ:

Нейронные сети – одна из самых горячих тем в машинном обучении последних лет. В докладе речь пойдет об основах DL: обратном распространении ошибки и стохастическом градиентном спуске. Мы обсудим MLP и сверточные сети. Как читать обозначения в статьях, что такое 1х1 и дырявые свертки. Чем global pooling отличается от обычного и т.д.

О КАНАЛЕ:

Официальный канал образовательных проектов Mail.Ru Group

Актуальные лекции и мастер-классы о программировании от лучших IT-специалистов. Если вы увлечены мобильной и веб-разработкой, присоединяйтесь!

Наши проекты:

------------------------

МЫ В СЕТИ:

Основы нейронных сетей и Deep Learning | Технострим

[DeepLearning | видео 1] Что же такое нейронная сеть?

Дмитрий Коробченко. Deep Learning. Обучение глубоких нейронных сетей...

Лекция. Рекуррентная нейронная сеть

Что такое глубокое обучение (Deep Learning) и почему это важно?...

ИИ, машинное обучение, НЕЙРОСЕТИ, Что есть что? | БОЛЬШОЙ РАЗБОР...

Семинар. Основы PyTorch. Обучение нейронных сетей.

Deep Learning: 1. Слои глубоких сверточных сетей

Архитектуры нейронных сетей. Часть 1: Базовые архитектуры...

DEEP LEARNING | Обучение глубоких нейронных сетей | Дмитрий Коробченко (NVIDIA)...

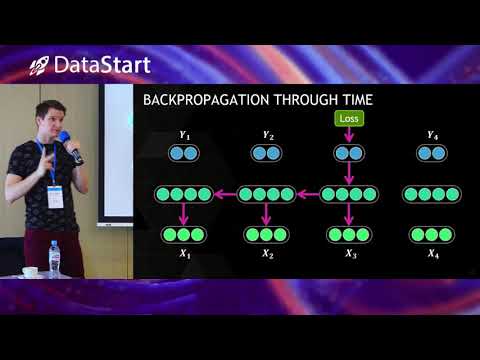

Дмитрий Коробченко - Современное состояние NLP на основе нейронных сетей - DataStart.ru...

Лекция. Сверточные нейронные сети

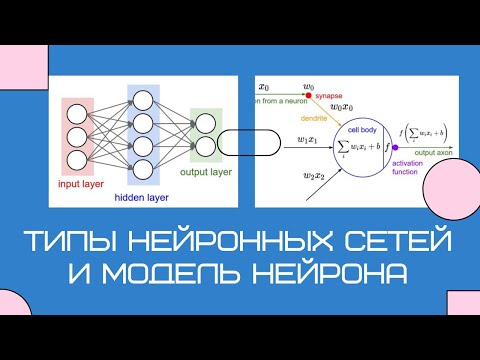

Типы нейронных сетей и модель искусственного нейрона

ОСНОВЫ ПРОГРАММИРОВАНИЯ ИСКУССТВЕННЫХ НЕЙРОННЫХ СЕТЕЙ...

Введение в Deep Learning | Григорий Сапунов (Intento)

Как Связаны Нейронные сети Машинное обучение Deep Learning с ИИ...

Deep Learning на пальцах 5 - Нейросети на практике

Мастер-класс: основы нейронных сетей

Modern Deep Learning (2023). Лекция 3. Целевая функция, метрики, обучение нейронной сети...

Учим Нейронные Сети за 1 час! | Python Tensorflow & PyTorch YOLO

Разновидности архитектур нейросетей | НЕЙРОСЕТЬ ИЗНУТРИ...

Нейронные сети за 10 минут

Алгоритмические основы обучения реккурентных нейронных сетей...

Твоя ПЕРВАЯ НЕЙРОСЕТЬ на Python с нуля! | За 10 минут :3

Комментарии

0:41:47

0:41:47

0:19:00

0:19:00

1:53:19

1:53:19

0:16:54

0:16:54

0:04:04

0:04:04

0:19:52

0:19:52

0:33:08

0:33:08

0:17:41

0:17:41

0:10:24

0:10:24

1:02:07

1:02:07

0:48:28

0:48:28

0:50:11

0:50:11

0:07:07

0:07:07

0:23:32

0:23:32

2:00:48

2:00:48

0:07:12

0:07:12

1:34:47

1:34:47

0:03:20

0:03:20

1:17:56

1:17:56

0:50:06

0:50:06

0:14:46

0:14:46

0:09:56

0:09:56

0:47:00

0:47:00

0:18:31

0:18:31