filmov

tv

DL2022: Нейронные сети (часть 1)

Показать описание

Курс "Глубокое обучение (Deep Learning)"

В этой лекции...

Простейшая нейросеть – 1 нейрон

Функции активации

(линейная, пороговая, сигмоида, гиперболический тангенс, softmax)

Функциональная выразимость нейрона

Теорема об универсальной аппроксимации

Сеть прямого распространения

В этой лекции...

Простейшая нейросеть – 1 нейрон

Функции активации

(линейная, пороговая, сигмоида, гиперболический тангенс, softmax)

Функциональная выразимость нейрона

Теорема об универсальной аппроксимации

Сеть прямого распространения

DL2022: Нейронные сети (часть 1)

DL2022: Архитектуры свёрточных нейронных сетей, часть 1 – чемпионы ImageNet и их «родственники»...

DL2022: Нейронные сети (часть 2)

DL2022: Визуализация нейронных сетей и генерация изображений (часть 1)...

DL2022: Свёрточные нейронные сети

DL2022: Вводная лекция (часть 1)

DL2022: Рекуррентные нейросети (часть 1)

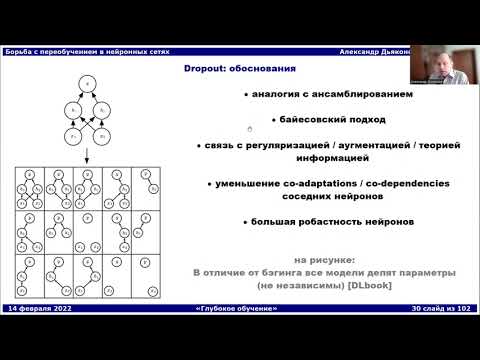

DL2022: Борьба с переобучением в нейронных сетях (часть 2)

Нейронные сети. Практика 1.

DL2022: Генеративные состязательные сети, часть 1

Нейронные сети. Лекция 1 - пример нейронной сети, основы работы, примеры датасетов...

Лекция 5. Генеративные сети, часть 1

Как нейронная сеть распознает текст? Лекция 1 по Advanced Computer Vision...

DL2022: Pytorch (часть 1)

Лекция. Сверточные нейронные сети

Екатерина Кондратьева | Нейронные сети на снимках МРТ мозга...

Введение в нейронные сети. Часть 2. Механизм обратного распространения ошибки...

Путь через искусственный интеллект и нейронные сети

DL2022: Трансформер (часть 1)

DL2022: Вариационный автокодировщик, часть 1

Глубинное обучение 1, лекция 7 - рекуррентные нейронные сети...

DL2022: Обучение без учителя, часть 1

DL2022: Векторные представления слов и текстов (часть 1)

DL2022: Визуализация нейронных сетей и генерация изображений (часть 2)...

Комментарии

0:33:04

0:33:04

1:33:02

1:33:02

1:44:05

1:44:05

1:12:20

1:12:20

1:59:36

1:59:36

1:28:26

1:28:26

1:27:52

1:27:52

1:57:50

1:57:50

0:10:35

0:10:35

1:16:45

1:16:45

1:34:35

1:34:35

2:02:44

2:02:44

1:13:21

1:13:21

0:55:56

0:55:56

0:50:11

0:50:11

0:20:17

0:20:17

0:26:19

0:26:19

0:31:36

0:31:36

0:58:38

0:58:38

1:06:12

1:06:12

1:19:24

1:19:24

0:51:11

0:51:11

0:57:03

0:57:03

1:17:03

1:17:03